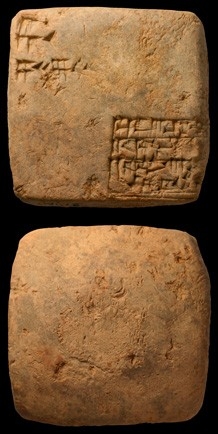

De très vieux brouillons d'écoliers : les tablettes mathématiques de Nippur

Les tablettes mathématiques de Nippur sont de très vieux brouillons mathématiques d'écoliers!

Vous trouverez les photos ICI.

Christine Proust a fait un travail énorme sur ces tablettes qu'elle a consigné dans un livre ICI.

Ce livre, préfacé par Christian Houzel, présente une collection de tablettes mathématiques d’époque paléo-babylonienne (début du deuxième millénaire avant notre ère) qui ont été exhumées à la fin du XIX e siècle par une mission archéologique américaine sur le site de Nippur (Mésopotamie centrale). Ces tablettes sont aujourd’hui conservées dans les musées archéologiques d’Istanbul, de Philadelphie et de Iéna. Le lot d’Istanbul est entièrement édité dans cet ouvrage et dans le CD qui l’accompagne (photos, copies, transcriptions). Les tablettes mathématiques de Nippur sont principalement des brouillons d’écoliers. Sans doute considérées comme trop élémentaires, elles avaient jusqu’à une date récente peu attiré l’attention des épigraphistes et des historiens, et elles étaient restées ignorées dans les réserves des musées. Pourtant, les tablettes scolaires apportent de précieux témoignages sur la vie intellectuelle qui s’est épanouie à Nippur, la grande capitale culturelle de la Mésopotamie, et notamment sur la place qu’y occupaient la langue sumérienne et les mathématiques, dans leurs raffinements les plus abstraits. L’étude des textes scolaires mathématiques, en prolongeant celles qui ont été menées sur les textes scolaires lexicaux et littéraires sumériens, permet une reconstitution remarquablement détaillée du cursus de formation des scribes. Précisément parce qu’ils sont des textes d’apprentissage, ces modestes brouillons d’écoliers donnent accès aux conceptions originales en matière de métrologie, de numération et de calcul qui étaient inculquées aux jeunes scribes et qui donc contribuaient au fond culturel des milieux érudits. Par ailleurs, trois textes mathématiques savants, dont un texte inédit conservé à Istanbul, ont été retrouvés à Nippur. Leur contenu est particulièrement intéressant, car il concerne différents aspects du calcul des volumes et des racines cubiques. Si on les aborde selon les conceptions élaborées par les scribes eux-mêmes, telles qu’elles leur ont été enseignées, et non au moyen de nos outils algébriques et arithmétiques actuels, ces textes livrent toute la singularité et la finesse des mathématiques qui se sont développées à cette époque.

La place du calcul dans l'enseignement, il y a 4000 ans : ICI

Le débat reste ouvert en attendant de futures publications sur le sujet. Malgré cela les scientifiques continuent à exercer leur dangereux métier, dont la principale motivation est "de permettre à ceux qui se trouvent dans ces situations de se faire entendre".

Le débat reste ouvert en attendant de futures publications sur le sujet. Malgré cela les scientifiques continuent à exercer leur dangereux métier, dont la principale motivation est "de permettre à ceux qui se trouvent dans ces situations de se faire entendre".