Les machins et les machines de Shannon

Claude Shannon s'est éteint en 2001. Ce fut un grand mathématicien doublé d'un grand talent d'électricien, ce qui fit de lui un précurseur dans le domaine de la transmission de l'information. Il en fit une théorie et c'est grâce ( ou à cause ) de lui que le schéma "Emetteur-Récepteur" s'est répandu comme une traînée de poudre.

Les "machins" de Shannon

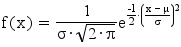

Le monde ne serait pas tel qu'il est aujourd'hui si Shannon n'avait pas apporté quelques "machins". Il a en fait été le premier à être en mesure d'expliquer quelles conditions devaient respecter un signal pour qu'il puisse être transmis sans dommage.

Les fondements de la théorie de l'information et des communications numériques modernes ont été posés par Claude Shannon il y a exactement soixante ans. En particulier, Shannon a établi une importante limite théorique concernant la qualité envisageable d'une transmission numérique, par le moyen d'un code correcteur d'erreurs, lequel restait à découvrir.

Durant cinquante ans, ce résultat théorique a constitué pour des milliers de chercheurs et d'ingénieurs un défi scientifique majeur car l'enjeu économique était important. Améliorer le pouvoir de correction d'un code, c'est à même qualité d'information reçue (par exemple en téléphonie numérique, pas plus d'une information binaire fausse sur 10.000 reçues), permettre au système de transmission de fonctionner dans des conditions plus sévères. Il est alors possible de réduire la taille des antennes, le niveau de puissance à l’émission ou le poids des batteries d'alimentation. Dans les systèmes spatiaux (satellites, sondes, ...), l'économie peut être considérable, car le poids des équipements et la puissance du lanceur s'en trouvent notablement réduits.Dans les systèmes cellulaires de téléphonie mobile, améliorer le code, c'est aussi permettre à l'opérateur d'augmenter le nombre d'utilisateurs potentiels dans la cellule ou d'accroître l'autonomie en énergie du portable.

En 1990, l’état de l’art était fixé par le code correcteur aujourd’hui utilisé dans la télévision numérique terrestre. Il s’agit d’un code concaténé ou code gigogne car deux codes emboîtés protègent mieux qu'un seul le message à transmettre comme le font deux enveloppes, au lieu d'une

seule, autour d'une feuille de papier. Mais la limite calculée par Shannon n'était toujours pas atteinte, d'un facteur deux à trois sur le rapport signal à bruit, et accroître le nombre de codes concaténés n'apporte apparemment aucun gain supplémentaire. On commençait donc à s'habituer à l'idée que la limite théorique était inaccessible.

Cet extrait est tiré du discours de Claude Berrou lors de la Séance solennelle de l’Académie des sciences / 17 juin 2008 Réception sous la coupole de l'Institut de France des Membres élus en 2007 pour sa nomination le 17 juin. Les travaux de Claude Berrou ont permis de s'approcher de cette limite théorique. On y trouve aussi lors de cette séance, deux autres mathématiciens Jean-Pierre Demailly et Roger Temam. On peut écouter les 11 intervenants et nouveaux membres de l'Académie des Sciences ci-après. Le discours de Claude Berrou débute à 1h18.

Les machines de Shannon

Si Shannon a fait faire à la science de l'information un pas géant, se distraction principale était sans aucun doute de construire des machines bien surprenantes. Il s'agit en fait de Juggling machines ou machines qui jonglent. Il découvrit même un juggling theorem ! ( Double-cliquez sur la vidéo).

C'est aussi à Shannon que l'on doit l'invention de la "most beautiful machine", surprenante machine qui nous fait un peu penser à la main de la famille Adams.